728x90

2023Langcon | Festa!

Festa에서 당신이 찾는 이벤트를 만나보세요.

festa.io

이번에 LangCon에 처음으로 참여하게 되었다. 2년전만 해도 BERT 모델링은 꿈도 못꾸는 시절이 있었다. 이 시기에 LangCon을 알고 있었지만 NLP 입문 과정이라 참여하지 못했다. 사실 이번 LangCon은 KoELECTRA, KLUE BERT로 유명하신 monologg(장원팍)님의 발표 세션이 있어 참여하게되었다. BERT를 접했다면 KoBERT-Transformers를 한번 쯤 보았을 것이다. BERT장인으로 Vocab 만들기 부터 Fine-Tuning까지 NLP 병아리들에게는 정말 좋은 가이드라인을 만들어 주셨다.

1) 우린 머신과 어떻게 다르게 이야기하나 (feat. 삼성전자 이종원님)

- ChatGPT에 대한 관심이 많은만큼 이번 발표 주제를 ChatGPT가 하지 못하는 점을 연구자의 시선으로 정리 해주셨다.

- 머신의 작동 원리

- Complex reasoning : 사람 간의 대화는 논리적이지 않을 수가 있다. (GPT는 문장의 참과 거짓을 떠나 논리 위주의 답만 Output으로 던저준다.)

- InstructGPT : GPT는 백과사전처럼 작동하기에 응용하기 상당히 어렵다. 또한 정치적인, 기호성이 강한 지식을 생성하는 문제가 많다. 이러한 점을 극복하고자 지시가 가능한 모델을 GPT에 적용했다.

- 데이터에 Supervised policy를 부여해 GPT를 FIne-Tunig을 한다. (-> SFT 모델)

- SFT 모델에 model의 output에 대한 평가(사용자의 기호에 맞게)를 부여한다. (Reward Model)

- Reward Model에 강화학습을 추가한다.

- 향후 넘어서야할 허들

- Track dialogue flow -> Dialouge Acts

- 화자의 의도 classification

- Request에 대한 응답(Decilne + inform 추가) (ChatGPT는 거부하지 못함)

- Semantic richness -> NL description

- 화자 응답에 대한 (조건 부여)

- Logic of speaking -> Chain-of-speech (CoS)

- 화자 응답에 대한 명확한 논리 전개(의미/ 사실-정보)를 응답에 추가

- Annotation 방식을 더 정확히

- Resigning Error

- Tackaways ...

- 기존 레퍼런스에 없는 모델링을 연구,, (BERT,, GPT 춘추전국 시대를 탈피할)

- Track dialogue flow -> Dialouge Acts

- 머신의 작동 원리

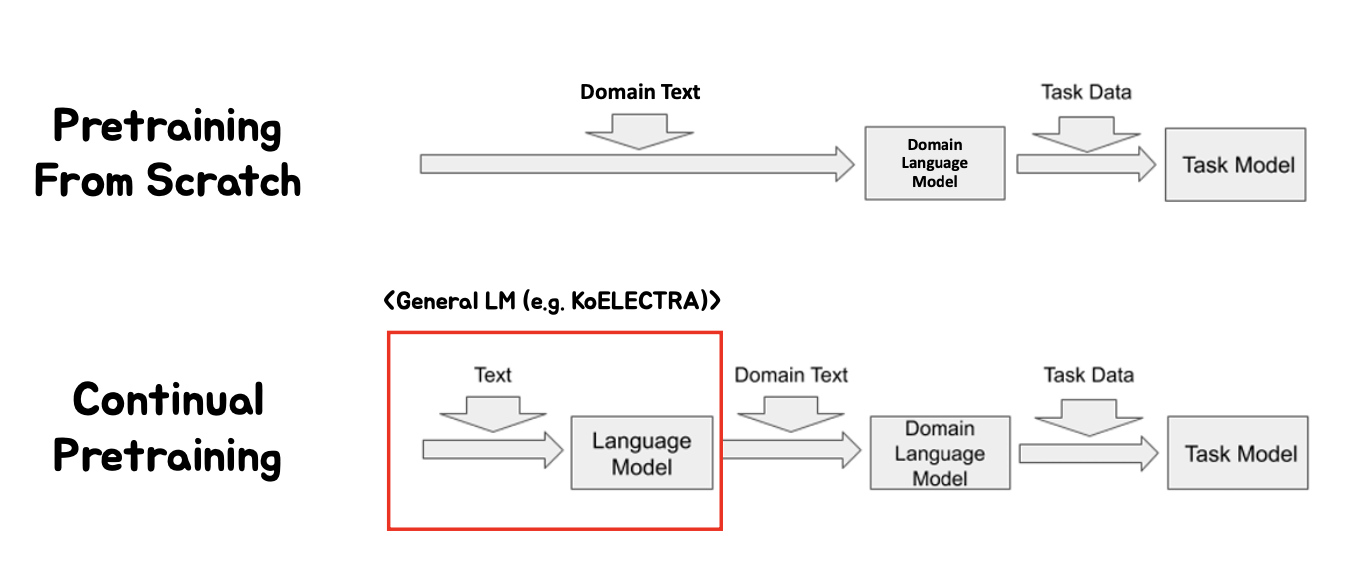

2) 특정 도메인에 맞는 언어모델은 어떻게 만들까? (feat. monologg님)

- ChatGPT? 어차피 BERT 쓸거자나.. 올바른 BERT 사용법

- 도메인 특화 언어모델이란?

- General(뉴스 일상) vs Domain(목적형 대화, 판례) / Corpus

- Domain : In-Domain (내 Task 범주) vs Out-Domain(Task 이외 범주)

- Require corpus dataset size

- Corpus dataset size 파악하기 (제일 중요.)

- 도메인 특화 언어모델이란?

- Tokenizer

- How Good is Your Tokenizer? On the Monolingual Performance of Multilingual Language Models (Rust et al., 2021) / 진짜 토큰 맞아?

- 단어 쪼개기 유의점 (subword size, 학교에 X 학교_, 에)

- 최소 2개이상의 subword로 쪼개지는 단어 분포

- Dataset (Domain 파악)

- DPR : negative likelihood loss -> triplet loss

- 학습이 어려움

- LM 가능

- Triplet loss에 의한 metric learning 적용

- LM의 성능을 담보로한 단일 인코더 문제로 변환

- Tokenizer

반응형

'🏃 Routine' 카테고리의 다른 글

| [AI BASIC 9기] 후기 (0) | 2023.02.25 |

|---|---|

| [Naver Cloud Server] 홈페이지 제작 - (3) 네이버 클라우드 데이터베이스 및 시각화 서비스 구현하기 (0) | 2023.02.24 |

| [Naver Cloud Server] 홈페이지 제작 - (2) 네이버 클라우드 가상서버 기반 웹사이트 및 개인도서관 서비스 구축하기 (0) | 2023.02.20 |

| [Naver Cloud Server] 홈페이지 제작 - (1) 클라우드 컴퓨팅과 네이버 클라우드 가상서버 구축해보기 (0) | 2023.02.19 |

| [python] Nasdaq Earning Date scraping Module (0) | 2023.02.02 |