Google VertaxAI Python SDK

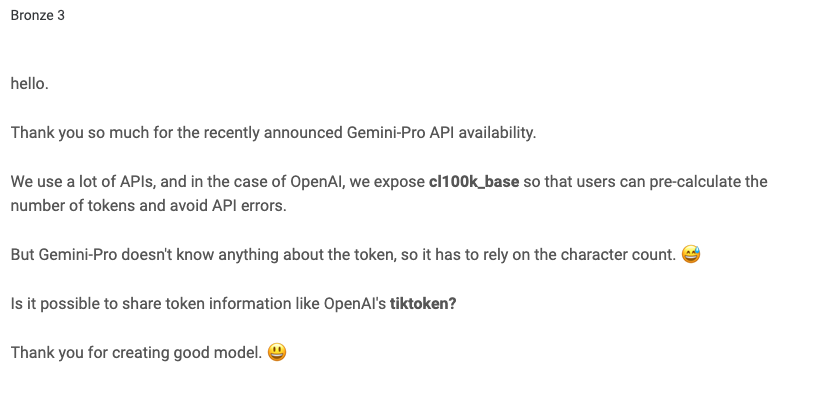

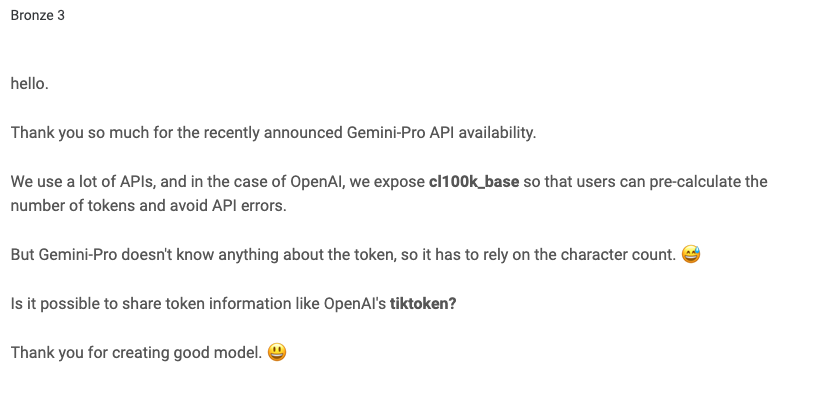

gemini tokenizer는 원래 공개되지 않아 token을 계산하려면 API를 사용해야 하는 번거로움이 있었다. 그래서 Google Cloud Community에 질문을 등록했다. 요는 tiktoken과 같이 token 계산을 local로 할 수있게 공개해 달라는 것이었다. token 수를 알 수 없으면 gemini-api를 사용할 때 max_token에 맞게 계속 조정해야 하기 때문에 수 차례 API를 사용해야 한다. 이런 문제를 의식했는지 token 수를 API로 활용할 수 있게 공개했지만 문제는 두 번의 API 사용도 마음에 들지 않았다.

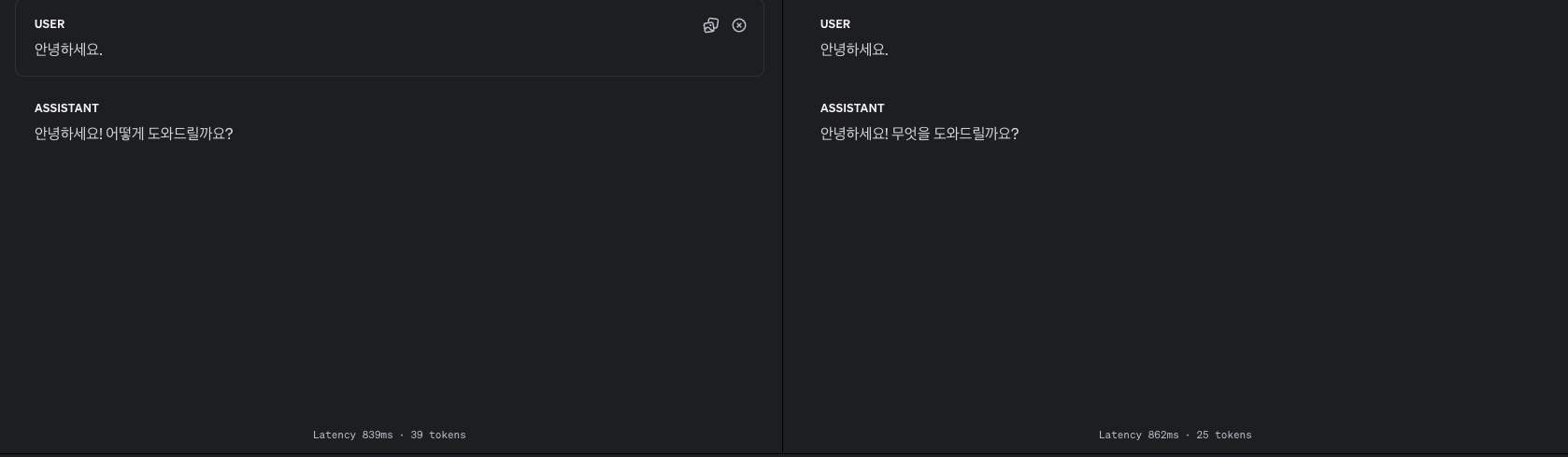

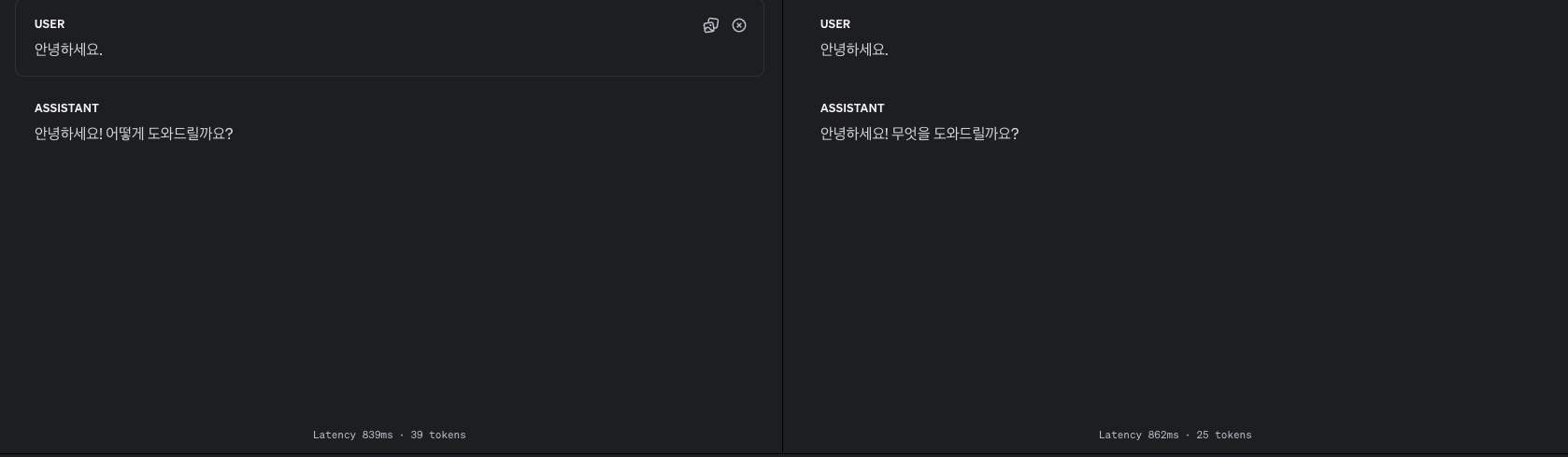

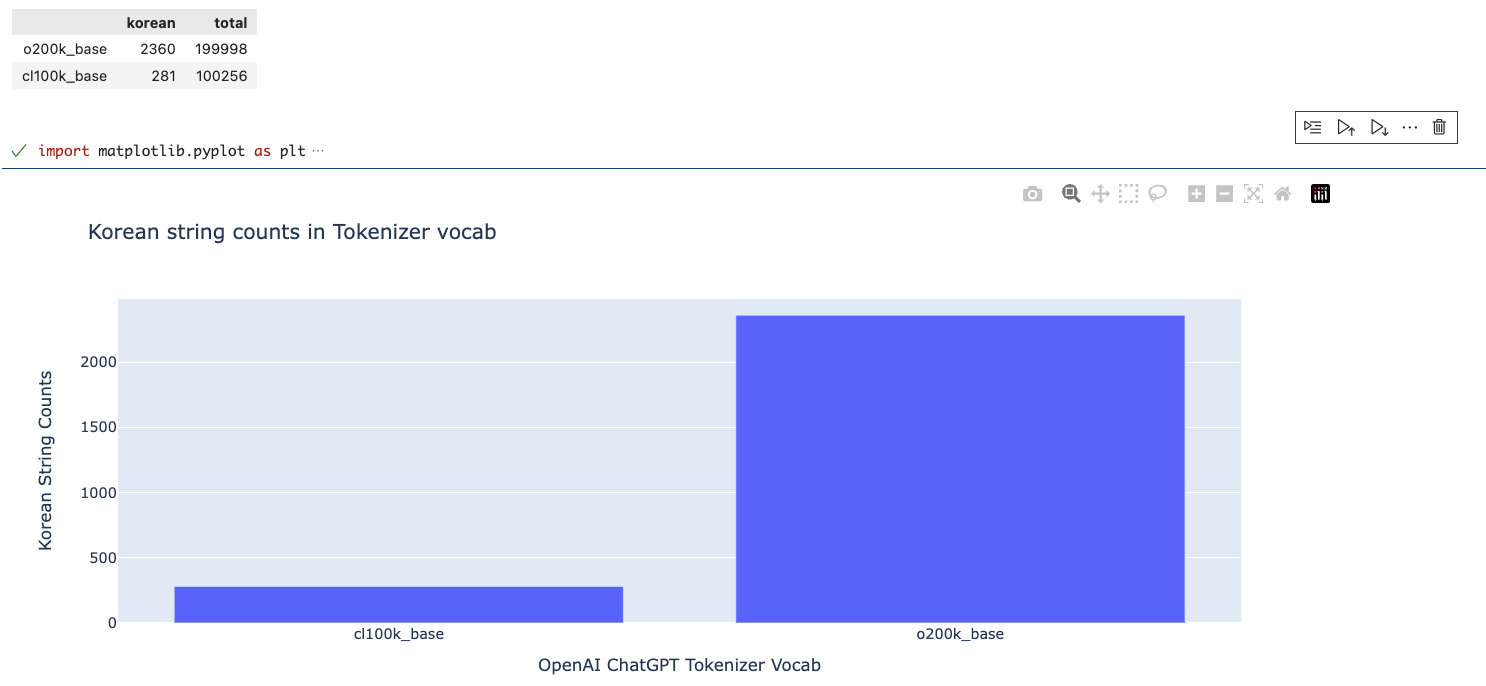

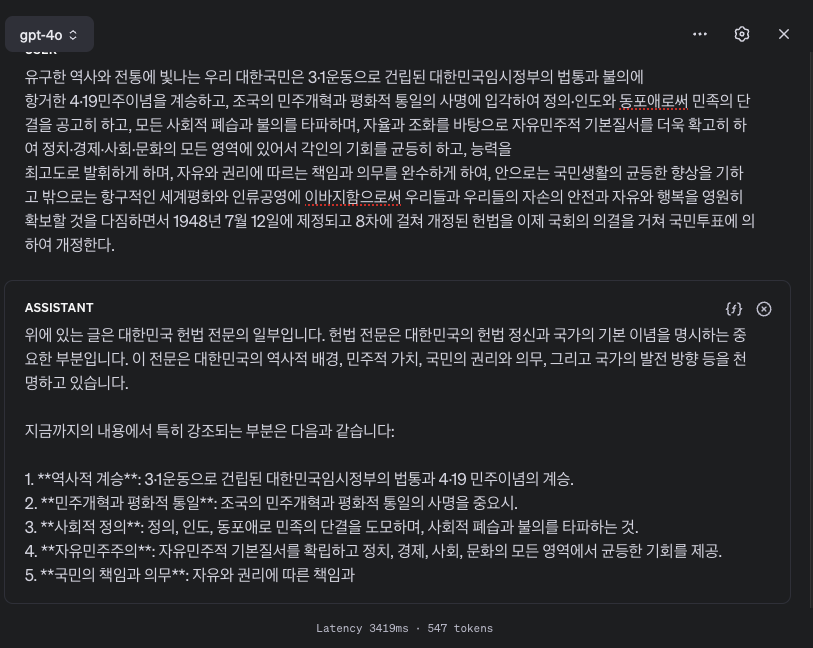

tiktoken으로 OpenAI에서는 tokenizer와 vocab을 공개해 투명하게 API 비용을 청구하고 있다. chatGPT의 vocab은 cl100k_base 10만 256개의 vocab을 가지고 추론에 사용한다. 이 중 한국어는 281개로 GPT3.5와 GPT 4.0 사용할때 엄청 느리고 토큰수를 많이 차지해 성능은 좋지만 서비스로 사용하기에 문제가 된다는 말을 많이 들었을 것이다. 아래 답변 결과를 보면 간단한 답변에도 40퍼센트나 차이가 난다.

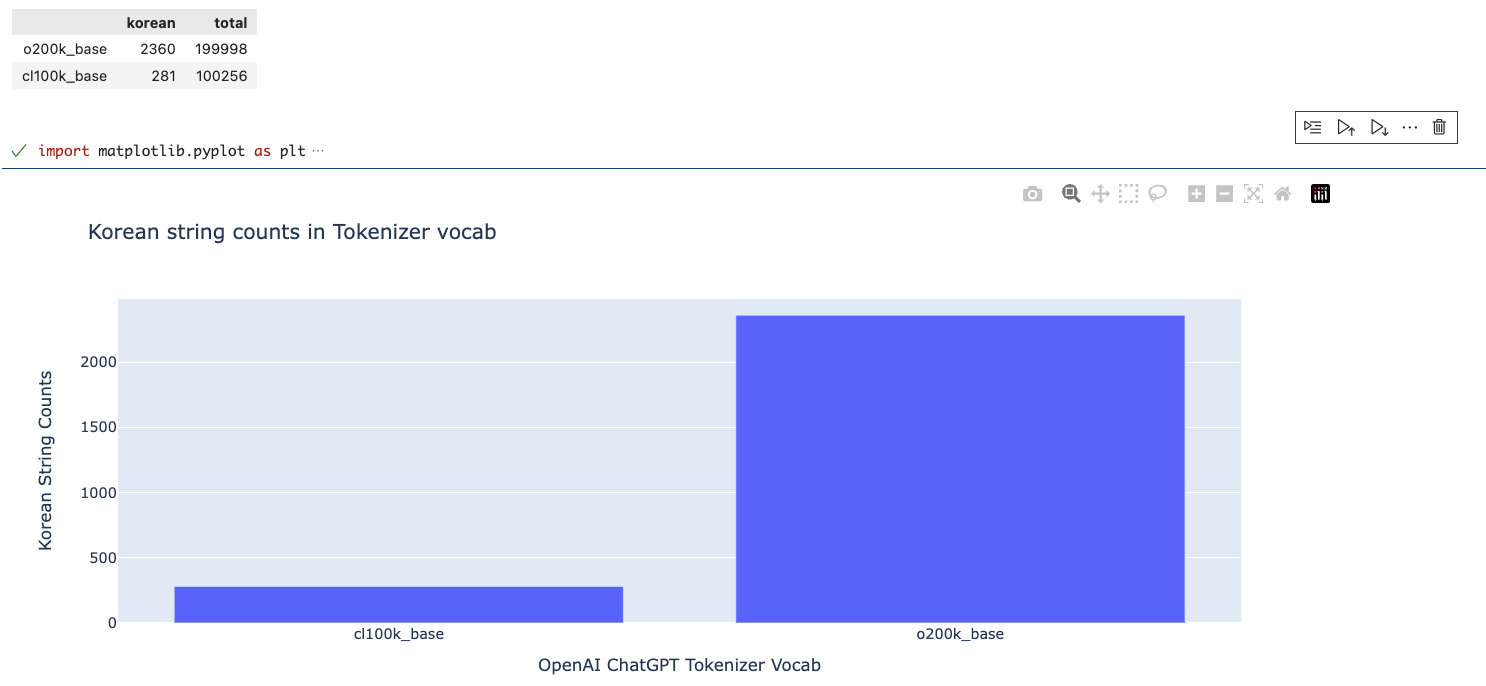

cl100k_base에는 한국어가 281개의 토큰이 o200k_base_vocab에는 2360개로 약 8배 정도 많이 반영이 되었다. 추론에서 토큰화는 정말 중요한데 이제서야 반영이 된 게 1년 동안 얼마나 많은 토큰이 낭비된 것인지 아쉽지만 개선해 준 것만으로도 감사하다.

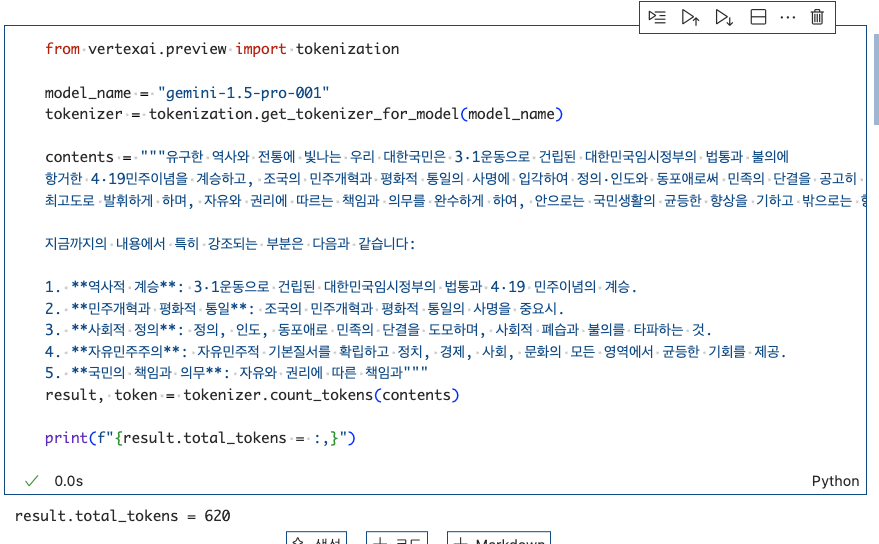

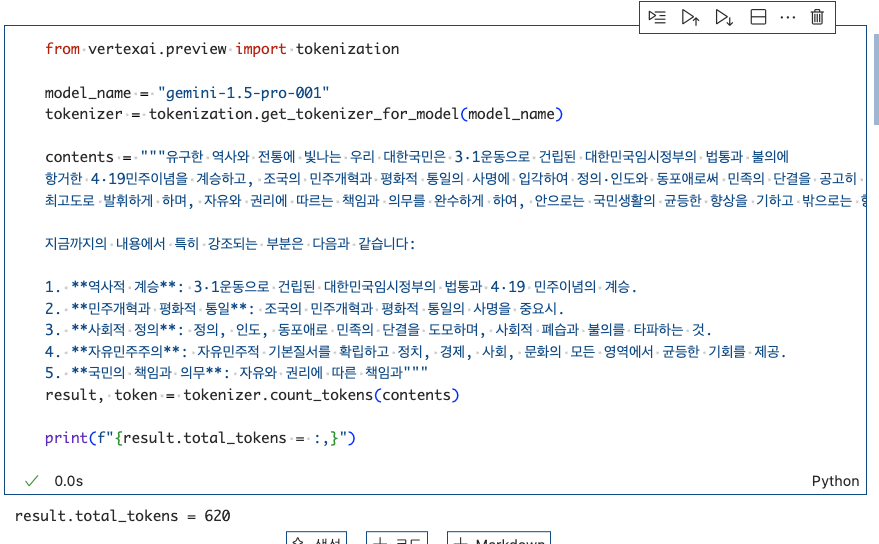

token의 중요성을 알았으니 Google VertaxAI Python SDK를 통해 gemini tokenizer를 local에서 사용해보자.

1. vertaxai 설치

python -m pip install --upgrade "google-cloud-aiplatform[tokenization]"

2. tokenization 모듈 실행

from vertexai.preview import tokenization

model_name = "gemini-1.5-flash-001"

tokenizer = tokenization.get_tokenizer_for_model(model_name)

contents = "안녕하세요. 안녕하세요! 궁금한 점이 있나요? 어떻게 도와드릴까요?"

result = tokenizer.count_tokens(contents)

print(f"{result.total_tokens = :,}")

#result.total_tokens = 28

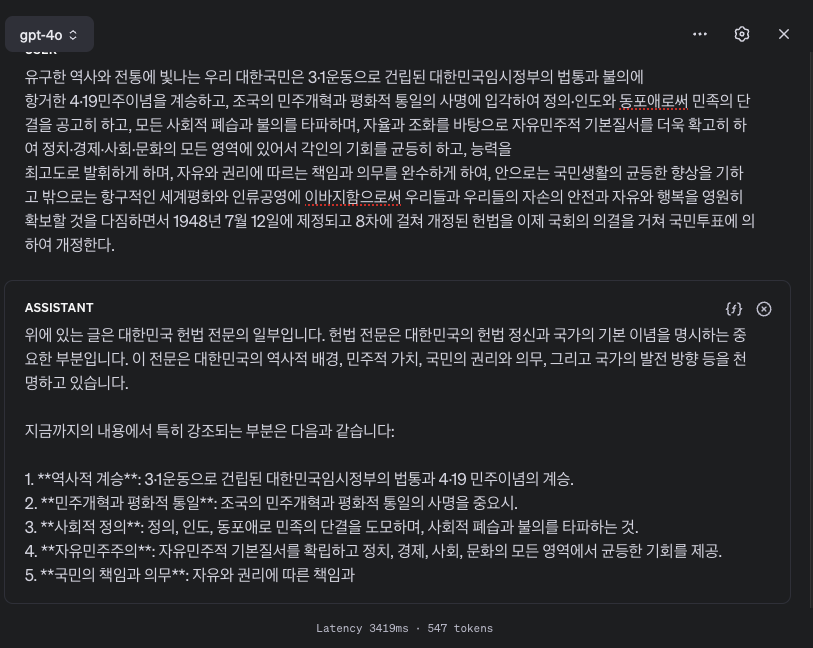

같은 input token과 output token의 차를 보면. 앞서 비교한 cl100k_base(39), o200k_base_vocab(25)개와 비교했을 때 효율적인 한국어 tokenzier는

o200k_base > gemini-tokenizer > cl100k_base

라고 할 수 있다.

가장 최근에 나온 모델이 GPT4o(o200k_base)인만큼 더 많은 것이 반영되어 있겠지만 아직 영어에 비해 많이 비효율적인 게 사실이다. 한국어 Foundation 모델이 나와야 이런 문제가 개선될 수 있는데 그러기에는 현실적으로 어려운 현실이다. 외국에서 만든 베이스 모델들이 한국어를 더 잘하는 것이 아쉽지만 그럼에도 연구는 계속되어야 한다고 생각된다. 특정 국가의 윤리관이나 역사의식이 반영된 LLM이 다른 국가에서 교육용으로 자리잡거나 서비스가 된다면 문제가 심각히 발생될 것으로 보인다. 네이버의 하이퍼크로버 X, LG AI 연구원의 엑사원 2.0, 삼성전자의 Gauss, NC소프트의 VARCO 등 성능이 좋지 않더라도 나중에는 따라잡을 것이라는 희망을 갖고 응원한다.

참고 문헌 )

https://www.googlecloudcommunity.com/gc/AI-ML/Please-share-Gemini-tokenize-information/m-p/773390

Re: Please share Gemini tokenize information

Thank you so much Now i can request just once not twice anymore ^^

www.googlecloudcommunity.com

https://platform.openai.com/playground/chat?models=gpt-3.5-turbo&models=gpt-4o

https://orange-mansion.com/news/240418_fm/

🍊오렌지맨숀 - “한국이 개발한 파운데이션 모델은 없다”

*다만 보고서에 누락될 수는 있습니다🤪

orange-mansion.com

'🛠️ Tools' 카테고리의 다른 글

| [Synology] Obsidian Webdav 연결 https (0) | 2024.11.24 |

|---|---|

| [Jupyterhub] 계정 생성 오류 (0) | 2024.08.15 |

| [Ollama] Response Structure Answer (0) | 2024.07.01 |

| [OpenAI] 모델별 지원 중단 예정 날짜, Model deprecations (0) | 2024.06.15 |

| [draw.io] sql문 가져오기 (0) | 2024.06.03 |

Google VertaxAI Python SDK

gemini tokenizer는 원래 공개되지 않아 token을 계산하려면 API를 사용해야 하는 번거로움이 있었다. 그래서 Google Cloud Community에 질문을 등록했다. 요는 tiktoken과 같이 token 계산을 local로 할 수있게 공개해 달라는 것이었다. token 수를 알 수 없으면 gemini-api를 사용할 때 max_token에 맞게 계속 조정해야 하기 때문에 수 차례 API를 사용해야 한다. 이런 문제를 의식했는지 token 수를 API로 활용할 수 있게 공개했지만 문제는 두 번의 API 사용도 마음에 들지 않았다.

tiktoken으로 OpenAI에서는 tokenizer와 vocab을 공개해 투명하게 API 비용을 청구하고 있다. chatGPT의 vocab은 cl100k_base 10만 256개의 vocab을 가지고 추론에 사용한다. 이 중 한국어는 281개로 GPT3.5와 GPT 4.0 사용할때 엄청 느리고 토큰수를 많이 차지해 성능은 좋지만 서비스로 사용하기에 문제가 된다는 말을 많이 들었을 것이다. 아래 답변 결과를 보면 간단한 답변에도 40퍼센트나 차이가 난다.

cl100k_base에는 한국어가 281개의 토큰이 o200k_base_vocab에는 2360개로 약 8배 정도 많이 반영이 되었다. 추론에서 토큰화는 정말 중요한데 이제서야 반영이 된 게 1년 동안 얼마나 많은 토큰이 낭비된 것인지 아쉽지만 개선해 준 것만으로도 감사하다.

token의 중요성을 알았으니 Google VertaxAI Python SDK를 통해 gemini tokenizer를 local에서 사용해보자.

1. vertaxai 설치

python -m pip install --upgrade "google-cloud-aiplatform[tokenization]"

2. tokenization 모듈 실행

from vertexai.preview import tokenization

model_name = "gemini-1.5-flash-001"

tokenizer = tokenization.get_tokenizer_for_model(model_name)

contents = "안녕하세요. 안녕하세요! 궁금한 점이 있나요? 어떻게 도와드릴까요?"

result = tokenizer.count_tokens(contents)

print(f"{result.total_tokens = :,}")

#result.total_tokens = 28

같은 input token과 output token의 차를 보면. 앞서 비교한 cl100k_base(39), o200k_base_vocab(25)개와 비교했을 때 효율적인 한국어 tokenzier는

o200k_base > gemini-tokenizer > cl100k_base

라고 할 수 있다.

가장 최근에 나온 모델이 GPT4o(o200k_base)인만큼 더 많은 것이 반영되어 있겠지만 아직 영어에 비해 많이 비효율적인 게 사실이다. 한국어 Foundation 모델이 나와야 이런 문제가 개선될 수 있는데 그러기에는 현실적으로 어려운 현실이다. 외국에서 만든 베이스 모델들이 한국어를 더 잘하는 것이 아쉽지만 그럼에도 연구는 계속되어야 한다고 생각된다. 특정 국가의 윤리관이나 역사의식이 반영된 LLM이 다른 국가에서 교육용으로 자리잡거나 서비스가 된다면 문제가 심각히 발생될 것으로 보인다. 네이버의 하이퍼크로버 X, LG AI 연구원의 엑사원 2.0, 삼성전자의 Gauss, NC소프트의 VARCO 등 성능이 좋지 않더라도 나중에는 따라잡을 것이라는 희망을 갖고 응원한다.

참고 문헌 )

https://www.googlecloudcommunity.com/gc/AI-ML/Please-share-Gemini-tokenize-information/m-p/773390

Re: Please share Gemini tokenize information

Thank you so much Now i can request just once not twice anymore ^^

www.googlecloudcommunity.com

https://platform.openai.com/playground/chat?models=gpt-3.5-turbo&models=gpt-4o

https://orange-mansion.com/news/240418_fm/

🍊오렌지맨숀 - “한국이 개발한 파운데이션 모델은 없다”

*다만 보고서에 누락될 수는 있습니다🤪

orange-mansion.com

'🛠️ Tools' 카테고리의 다른 글

| [Synology] Obsidian Webdav 연결 https (0) | 2024.11.24 |

|---|---|

| [Jupyterhub] 계정 생성 오류 (0) | 2024.08.15 |

| [Ollama] Response Structure Answer (0) | 2024.07.01 |

| [OpenAI] 모델별 지원 중단 예정 날짜, Model deprecations (0) | 2024.06.15 |

| [draw.io] sql문 가져오기 (0) | 2024.06.03 |